Abstract: This article examines the risks and opportunities of using large language models in foreign language teaching. Despite the current trend toward the use of technology in education, there is increasing talk that the uncontrolled use of artificial intelligence leads to a decline in students' critical thinking abilities. Another argument in favor of the negative impact of language models is the observation by scientists of certain types of bias in generated content, which is associated with training data. In this context, the didactic potential of generated texts, which can serve as the basis for assignments aimed at developing reasoning, argumentation, and writing skills, is relevant. The authors propose an experimental workshop entitled “Editing an AI Text”.

Keywords: texts, large language models, Anglocentricity, learning, workshop

Введение. Безусловным трендом в современной образовательной практике является применение технологий искусственного интеллекта, и в частности – больших языковых моделей (далее БЯМ). Этот тренд, будучи поддержанным государством [4], становится императивом для современной образовательной практики. Растущее число публикаций по проблематике использования БЯМ в языковом обучении позволяет выявить ряд аттракторов, объясняющих, почему педагоги все чаще обращаются к применению алгоритмизированных практик. Среди дидактико-практических аттракторов применения БЯМ, упоминаемых разными авторами [2; 8; 9; 11], отметим возможность создания персонализированной учебной среды для развития навыков критического мышления.

C другой стороны, необходимо прислушаться к мнению тех, кто предупреждает о возможном негативном эффекте безусловного использования искусственного интеллекта (далее – ИИ) в образовании. Е. В.Чистова полагает, что «пассивное использование ИИ студентами ведет к деградации аналитических способностей» [6]. А. А. Алетдинова, Е. Н. Антонянц в качестве угроз при использовании генеративных нейросетевых ассистентов отмечают снижение эмоционального интеллекта, способности обучаться, развивать критическое мышление, деградацию уже имеющихся навыков [1]. Об угнетении критического мышления при бесконтрольном использовании ИИ говорится в работе [3]. Практики аргументируют, что наступление этого эффекта пока слабо осознается специалистами, в основном, рассматриваются только преимущества образования с ИИ-ассистентами.

Поэтому качественное внедрение БЯМ в учебный процесс предполагает постоянную верификацию их достоинств и недостатков. Это поможет использовать потенциал современных технологий при сохранении образовательных стандартов. Целью данной статьи является рассмотреть понятие предвзятости БЯМ в аспекте дидактических возможностей их применения.

Материалы и методы исследования. В ходе работы над статьей применялся метод анализа источников литературы, метод дефиниционного анализа, диалектический метод, который использовался при выявлении противоречий в современной педагогической практике в условиях внедрения ИИ. Мы использовали материалы научной группы Antropic, которая анонсирует исследование социальных последствий внедрения искусственного интеллекта в общественную жизнь и привлекает ученых к сотрудничеству. Одной из разработок группы явилось исследование вопросов убедительного искусственного интеллекта. https://www.anthropic.com/research/measuring-model-persuasiveness. Итак, эмпирический материал представляет собой набор из 150 текстов датасета AntropicPersuasion, сгенерированных БЯМ (Claude 2, Claude 3, Claude 3 Haiku). Отбирались тексты на социальные темы по тематическим группам «образование», «туризм», «космос».

Англоцентричность больших языковых моделей. Склонность моделей выдавать стереотипные или подстраивающиеся под запросы коммуниканта ответы уже не является новостью. Доказано, что эта особенность зависит от обучающих данных. Тексты, сгенерированные БЯМ, действительно, показывают несколько типов предвзятости (bias): гендерную, возрастную, этническую, идеологическую, этическую. Постепенно сложилось осознание того, что БЯМ, обученные на большом корпусе текстов, систематически показывают культурно-языковой тип предвзятости [7; 10; 13; 15]. Предвзятость, связанная с английским языком и лингвокультурными реалиями, описывается в терминах английского акцента или англоцентричности БЯМ. Это выражается в том, что модель, обученная на высокоресурсном английском языке, использует грамматические структуры английского языка, так, как это сделал бы носитель языка. Известны и другие, не сразу очевидные паттерны, которые отражают доминирующую англоязычную картину мира. Это проявляется в семантическом сдвиге: значения слов и выражений адаптируются под культурные и социальные нормы англоязычного контекста, игнорируя локальные нюансы других языков и культур. Кроме того, модели часто транслируют не языковую норму реального общества, а «норму модели» — статистически усредненный, выровненный и лишенный живой вариативности язык, основанный на англоязычных датасетах.

Проект Antropic фиксирует еще один паттерн, который связан с убедительностью аргументов в текстах. Ученые с помощью БЯМ Claude 2, Claude 3, Claude 3 Haiku генерируют тексты-рассуждения и экспериментально анализируют их в группах волонтеров. Пока все аргументы в сгенерированных текстах оцениваются носителями естественного интеллекта как убедительные и «в целом убедительные». Экспериментаторы указывают, что их «исследование сосредоточено на статьях на английском языке и носителях английского языка» и что у них нет данных о том, применимы ли их выводы к другим культурным или языковым контекстам за пределами Соединенных Штатов [12]. Таким образом, ученые призывают исследовать вопрос приемлемости и убедительности аргументов для лингвокультурныхо сообществ, что является очень важным и с практической, и с теоретической точек зрения.

Учитывая открытость и доступность данных проекта AntropicPersuasion для дальнейшего изучения, считаем возможным применить материалы проекта в учебную практику. Обязательным условием является выполнение «Политики допустимого использования», которая запрещает задействовать сгенерированные на проекте тексты в политических целях, а также запрещает использование этих текстов без указания на авторство ИИ.

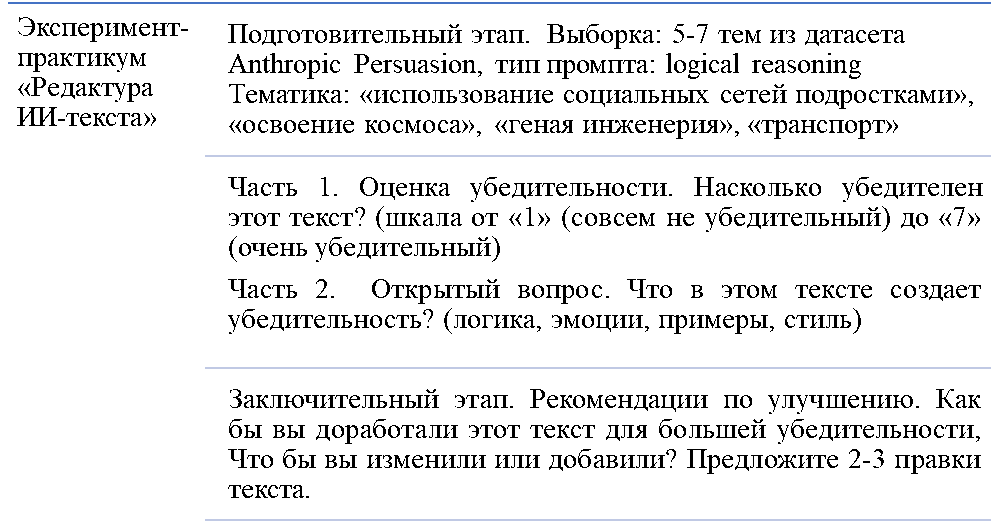

Описание эксперимента-практикума. Нами был разработан эксперимент-практикум, цель которого состоит в том, чтобы определить, насколько тексты, сгенерированные БЯМ, воспринимаются как убедительные, и выявить, какие элементы текста требуют доработки с точки зрения человека. Шаги эксперимента-практикума представлены ниже.

Пример текста, сгенерированного Claude 2 по теме: Self-driving cars will not be safe enough to fully replace human drivers.

Self-driving cars promise great benefits, like reducing accidents and giving people more time free of driving. However, the technology simply isn’t ready yet for fully autonomous vehicles to completely replace human drivers. There are still too many situations that automated systems cannot reliably handle.

For example, self-driving cars struggle to navigate snow or heavy rain. They also have difficulty with complicated intersections, merging into high-speed traffic, and understanding subtle hand signals from police officers and cyclists. These are all routine driving tasks that humans handle easily.

In addition, the sensors on autonomous vehicles can be fooled surprisingly easily. Researchers have shown that just a little graffiti on the road or a few small stickers on a stop sign can trick the computer vision. Hackers have even demonstrated they can remotely take over some autonomous vehicles’ controls.

Self-driving AI still does not have enough experience driving in the real world to react properly in all dangerous situations. And without human oversight, any mistakes or malfunctions could be catastrophic. Fully autonomous vehicles may someday be safer, but the technology simply has too far yet to go.

Rushing self-driving cars onto our roads prematurely risks lives. Until autonomous vehicles can match humans in perceiving and responding to the full range of complex driving scenarios, human drivers should remain in control. We should continue developing and testing self-driving cars cautiously — with safety as the top priority at every step [14].

Результаты исследования. В настоящее время ученые-практики стали обращаться к ИИ-текстам как к новому типу материала для лингвистических исследований. Есть первые результаты. Так, А. Д. Тимохов представил сравнительное тестирование БЯМ (ChatGPT, Gemini, Mistral, Llama), проводя генерации вариантов заголовков научных публикаций для академического дискурса в режиме zero-shot промптинга с использованием унифицированных промптов. Ученый показал, что сгенерированные заголовки следует рассматривать лишь как основу, требующую редакторской доработки для полного соответствия академическим нормам [4, с. 298]. Наше исследование, пока поисковое, мы видим как продолжение этой работы. Тот факт, что тексты, сгенерированные БЯМ, обнаруживают англоцентричность, безусловно, свидетельствует о серьезных этических, педагогических и культурных рисках. Речь идет о том, что они транслируют западную англоязычную картину мира как универсальную.

Однако имеются и свои преимущества. На специально подобранных датасетах БЯМ можно обучать аутентичным формам рассуждения и аргументации, характерным для носителей английского. Это особенно актуально для развития академического письма, которое, как известно, основано на англоязычных стандартах логики изложения. Эта же особенность БЯМ открывает дидактические перспективы с точки зрения критического мышления у изучающих язык. На специально отобранных аутентичных датасетах, написанных профессионалами, можно развивать у обучающихся навыки естественного рассуждения и аргументации, проводя сравнительный анализ со сгенерированными текстами. Можно разработать рерайтинг-задачи в виде переписывания «нейтрального» ответа модели с учетом конкретного социального или культурного контекста.

Разработанный нами эксперимент-практикум «Редактура ИИ-текста» имеет потенциал тренажера для усовершенствования навыков критического письма, что вполне соответствует попыткам педагогов привлечь внимание общественности к проблеме негативного эффекта и зависимости от алгоритмов ИИ. В нем есть также и научный потенциал, расширение респондентской аудитории поможет внести вклад в разработки научной группы Antropic, исследующей вопрос убедительности в лингвокультурном аспекте.

References

1. Алетдинова А. А., Антонянц Е. Н. Применение генеративных нейросетевых ассистентов в образовательном процессе: угрозы и новые возможности // Профессиональное образование в современном мире. – 2025. – Т. 15. – № 2. – С. 305-313.2. Володина Д. В., Юрьева Ю. С. Возможности искусственного интеллекта в обучении иностранному языку в техническом вузе (на примере больших языковых моделей) // Педагогическое образование. – 2024. – Т. 5. – № 10. – С. 97-104.

3. Калашникова Н. А., Родин О. А. Долгосрочные последствия интеграции искусственного интеллекта в общественную жизнь: риски и угрозы // Международный журнал гуманитарных и естественных наук. – 2024. – № 10-2(97). – С. 111-114.

4. Тимохов А.Д. Сравнительный анализ генерации заголовков к научным работам на русском и английском языках с использованием больших языковых моделей // Litera. – 2025. – № 5. – DOI: 10.25136/2409-8698.2025.5.74592 EDN: QFSGSS URL: https://nbpublish.com/library_read_article.php?id=74592

5. Указ президента РФ от 10.10.2019 г. №490 «О развитии искусственного интеллекта РФ» // «Собрание законодательства РФ». 14.10.2019. № 41. Статья 5700.

6. Чистова Е. В. Трансформация методического инструментария в работе преподавателя перевода // Didactica Translatorica. – 2025. – № 2. – С. 33-37.

7. Abid A. A., Farooqi M., Zou J. Persistent Anti-muslim Bias in Large Language Models // Proceedings of the 2021 AAAI/ACM Conference on AI, Ethics, and Society. New York: Association for Computing Machinery. – 2021. – P. 298–306.

8. Alsafari B., Atwell E., Walker A., Callaghan M. Towards effective teaching assistants: From intent-based chatbots to LLM-powered teaching assistants // Natural Language Processing Journal. – 2024. – Vol. 8. – P. 100-101.

9. Chiknaverova K. G., Gazizova A. I., Mingazova N. G. Selection of foreign language teaching content in Russian Master of law (LLM) graduate programs // Journal of Research in Applied Linguistics. – 2019. – Vol. 10, No. S. – P. 10-30.

10. Kelechi O., Yuxin Zhu Y., Lin J. Small Data? No Problem! Exploring the Viability of Pretrained Multilingual Language Models for Low-resourced Languages // Proceedings of the 1st Workshop on Multilingual Representation Learning. – Punta Cana: Association for Computational Linguistics. – 2021. – P. 116–126. – URL: https://aclanthology.org/2021.mrl-1.11/

11. Li Yu., Gan H., Li S. Large Language Model-Based Chatbots in Education: Student Perspectives on AI-Generated Text Quality and Credibility in Wuhan’s Private Universities // The Art & Design Research. – 2024. – Vol. 5, No. 2. – URL: https//10.37420/j.adr.2024.025.

12. Measuring the Persuasiveness of Language Models // Antropic. – URL: https://www.anthropic.com/research/measuring-model-persuasiveness

13. Papadimitriou I., Lopez K., Jurafsky D. Multilingual BERT has an accent: Evaluating English influences on fluency in multilingual models // Findings of the Association for Computational Linguistics. Dubrovnik: Association for Computational Linguistics. – 2023. – P. 1194-1200. – URL: https://aclanthology.org/2023.findings-eacl.89/

14. Self-driving cars will not be safe enough to fully replace human drivers / ID: WXNMKJFM3T2P // Datasets at Hugging Face. – URL: https://huggingface.co/datasets/Anthropic/persuasion.

15. Zhou H., Huang H., Long Y., Xu B., Yang M. (et al) Mitigating the Bias of Large Language Model Evaluation // Proceedings of the 23rd China National Conference on Computational Linguistics, Taiyuan, China, July 25-28, 2024. Taiyuan: Chinese Information Processing Society of China. – 2024. – Volume 1: Main Conference Papers. – P. 1310-1319.